¿Cómo saber si una foto se hizo con IA? El gran reto de las tecnológicas

A principios del 2023, una serie de imágenes generadas por IA del Papa con un look “no convencional” dieron la vuelta al mundo, con un debate entre la veracidad de las fotografías.

De primera instancia, las imágenes pueden parecer tomadas por un fotógrafo real, no obstante, al observar los detalles se aprecian diversas irregularidades, desde los rostros de las personas al fondo, hasta la “mala generación” de manos. Sin embargo, la IA está en constante aprendizaje, por lo que hoy en día las imágenes se han vuelto más realistas, perfeccionando los detalles.

"Los modelos se están volviendo cada vez más sofisticados y hemos experimentado un aumento enorme en el número de personas que utilizan la tecnología", comentó Thomas Kurian, director ejecutivo de Google Cloud.

Las fotografías del Papa, dieron la pauta para abordar las consecuencias sobre archivos generados por IA, desde la difusión de ‘fake news’ hasta el posible valor artístico de cada imagen.

Uno de los principales retos que las grandes compañías abordaron fue la creación de protocolos y medidas para detectar archivos generados por IA, misión que al menos 7 empresas del rubro han impulsado, la más reciente Google.

La unidad de Google DeepMind anunció SynthID, una herramienta de identificación/marca de agua para arte generativo. La tecnología está diseñada esencialmente para “marcar” una imagen generada por IA de una manera imperceptible para el ojo humano, pero fácilmente captada por una herramienta tecnológica.

Google plantea la detección de imágenes como una medida necesaria ante la creciente demanda de tal tecnología y los riesgos que se puede generar para eventos de importancia social, como las próximas elecciones en Estados Unidos y México.

“Cada vez que hablamos de este y de otros sistemas, nos preguntamos: '¿Qué pasa con el problema de los deepfakes? Construir sistemas para identificar y detectar imágenes de IA es cada vez más importante”, explicó Demis Hassabis director ejecutivo de Google DeepMind.

Google detalló que la 'marca de agua' se encuentra incrustada en los píxeles de las imágenes, asegurando que no altera de manera significativa la calidad ni la experiencia visual de las mismas.

De igual manera, la compañía detalló que es resistente a diversas transformaciones o intentos de “burlar” la identificación: recortar, cambiar el tamaño, modificar el color e incluso comprimir el archivo.

SynthID se implementará en primera instancia para el ecosistema de Google Cloud, aunque a medida que el sistema se pruebe, la compañía planea expandir su compatibilidad con más softwares de generación de imágenes y crear un estándar para todo Internet.

“La cuestión es ampliarla, compartirla con otros socios que la quieran y luego ampliar la solución para el consumidor, y luego tener ese debate con la sociedad civil sobre hacia dónde queremos llevar esto”, explicó Hassabis.

Las empresas de IA se unen al juego

Google no es la única empresa con esta ambición en la detección de contenido generado a partir de IA. Meta, Microsoft, Adobe y OpenAI, prometieron incorporar protecciones y sistemas de seguridad para identificar su contenido realizado por IA, en conjunto con el gobierno estadounidense.

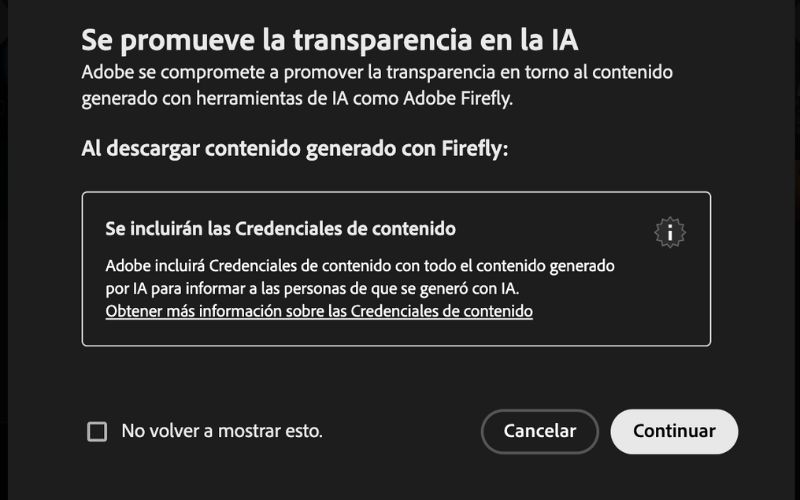

Bajo el nombre ‘Coalición para la Procedencia y Autenticidad del Contenido’ (C2PA), las compañías buscan crear un estándar para la detección de archivos realizados con inteligencia artificial generativa, así como rastrear imágenes y adjudicar el origen de la misma.

Además, tanto Adobe con Firefly como Microsoft con Bing colocan marcas de agua visibles para el ojo humano en la esquina de las imágenes generadas por sus herramientas de IA, como otra medida para informar a los consumidores sobre el origen de las imágenes.

Las pequeñas empresas también buscan tener un papel en la solución de esta problemática. Hive, una empresa de inteligencia artificial que etiqueta contenido, se mantiene en constantes actualizaciones para mejorar su detector gratuito de contenido generado por IA. Hive estima que detecta con precisión alrededor del 95% de las imágenes creadas de manera generativa.

La herramienta de Optic examina artefactos en cada imagen que son invisibles al ojo humano, como variaciones de brillo y color en las imágenes, De acuerdo con Andrey Doronichev, director ejecutivo, la herramienta tiene una tasa de precisión del 88,9%.

IA mejora día a día

A medida que la IA mejora en la creación de imágenes y videos, se abre la brecha del ojo humano para distinguir entre lo real y lo falso. Tan solo la generación de rostros y manos, se ha perfeccionado en la mayoría de herramientas de creación generativa.

Para comprobarlo, solicitamos a las principales plataformas (gratuitas) la creación de un rostro humano y una mano. Los resultados, aunque distintos entre cada herramienta, presentan un avance significativo desde el boom de la IA a principios de año.

En la primera prueba se solicitó a Canva, Adobe Firefly y Microsoft Bing, la generación de un rostro con esta indicación: “Rostro humano realista”.

De igual manera, se solicitó a las mismas herramientas la siguiente indicación: “Mano, realista”

Los resultados muestran el gran avance que se ha generado en los últimos meses, habrá que ver como se mantiene la evolución en la creación de imágenes a partir de IA y las medidas de seguridad y prevención de “fake news” por parte de las compañías y los distintos gobiernos.